Segmentieren und Greifen von Objekten in dynamischen Umgebungen

Wichtigsten Punkte auf einen Blick

- Nachtrainiertes YoloV11-Modell zur Erkennung eigener Objektklassen

- Kleiner Datensatz (8 Objektklassen, 500 Bilder pro Klasse) genügt zum Nachtraining

- Inferenz des YoloV11-Modells und Steuerung des Roboterarms mit Raspberry Pi 4

- Bestimmung einer optimalen Griffposition unter Berücksichtigung der Greifer- und Objektgeometrie

Kurzbeschreibung

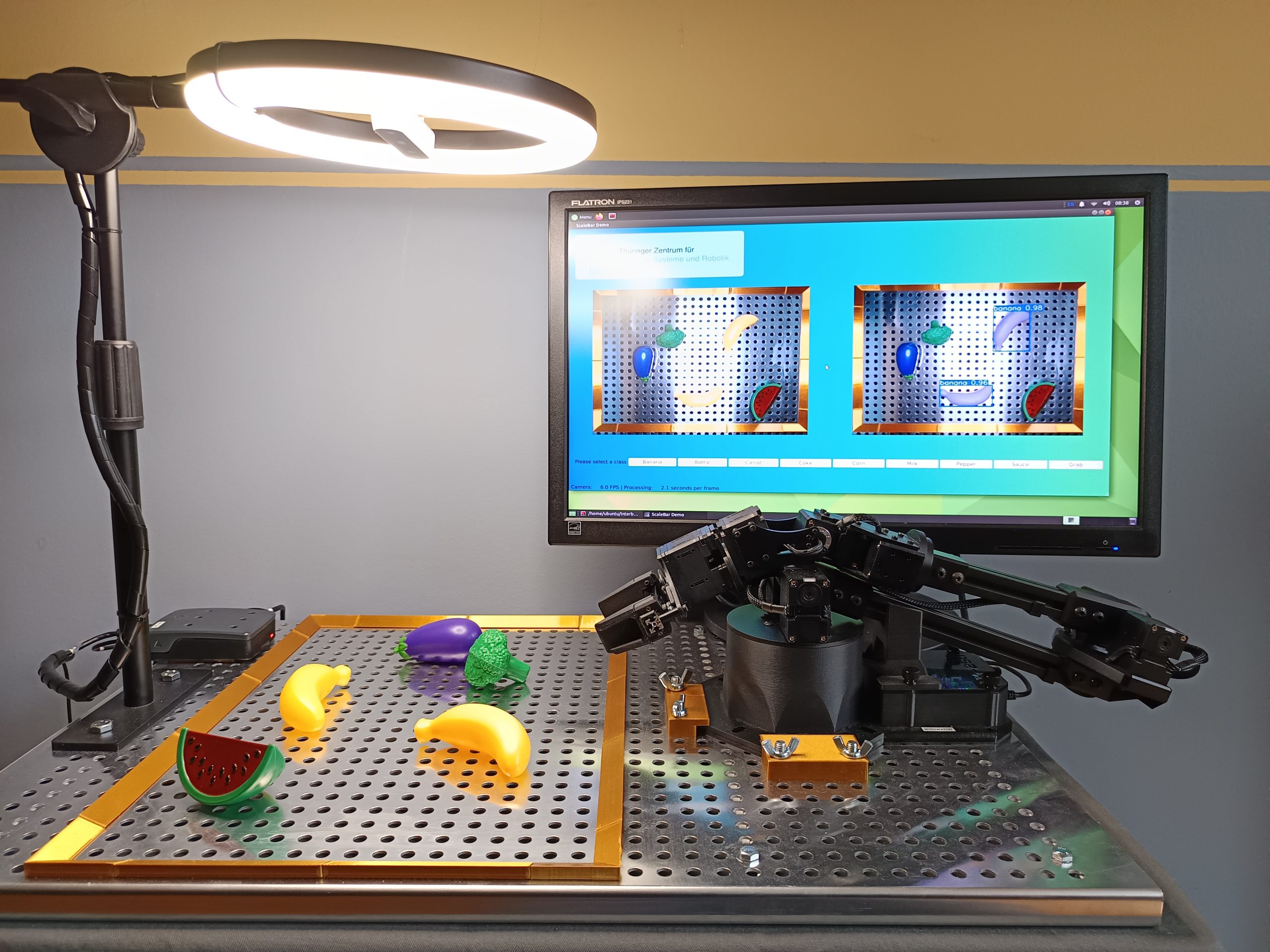

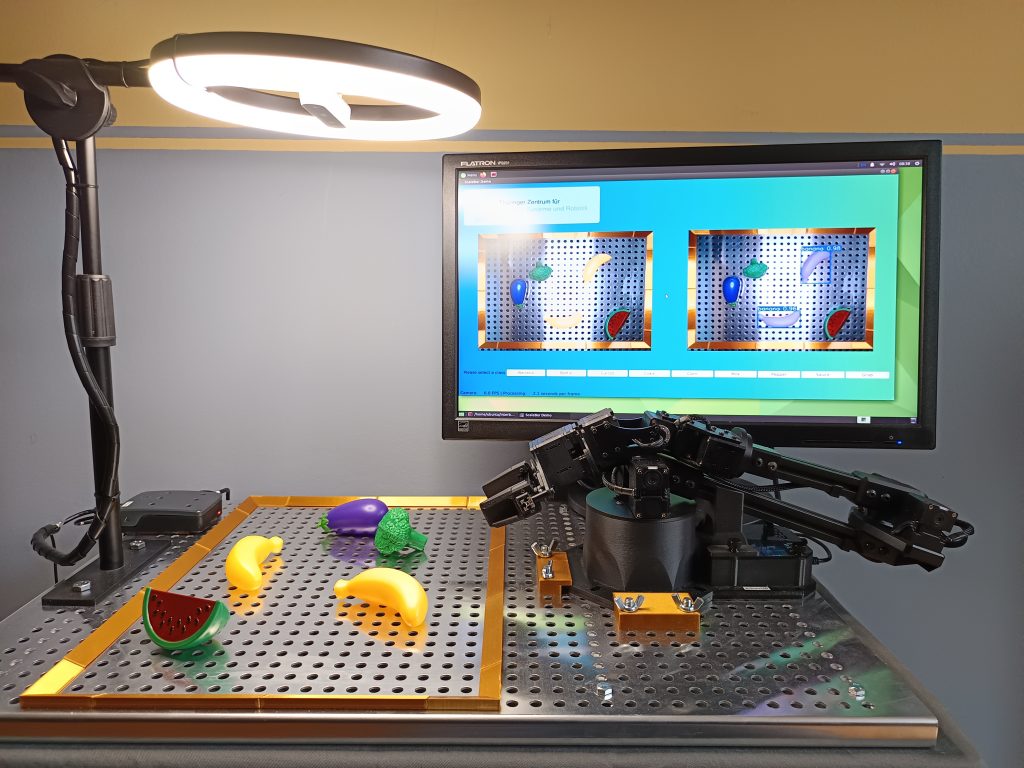

Der Demonstrator zeigt das Greifen beliebiger Objekte in dynamischen Szenen unter Nutzung eines Roboterarms und eines an die Aufgabenstellung angepasstem Klassifikations- und Segmentierungsmodells (YoloV11).

Zum Erreichen der Zielstellung wurde ein Datensatz mit Bildern der relevanten Objektklassen erzeugt und damit das Modell nachtrainiert. Der Datensatz ist mit ca. 500 Bildern pro Klasse relativ klein. Das Training erfolgte auf einem PC mit Grafikkarte (Nvidia GeForce RTX 4070), für die Anwendung (Inferenz) des Modells wird ein Raspberry Pi 4 genutzt. Die Segmentierung erfolgt mit 1,5 FPS.

Der verwendete Roboterarm ist ein WidowX 250s der Firma TrossenRobotics. Er besitzt 6 Freiheitsgrade, eine Auslage von 50cm und einer max. Payload von 250g.

Für die Objekterkennung wir das Farbbild der Intel Realsense D415, welche über dem Arbeitsbereich des Roboters montiert ist. Aus den erkannten Objekte kann eine Klasse ausgewählt werden, deren Objekte vom Roboterarm gegriffen werden sollen. Dabei wird ausgehend von der Lage des Objektes sowie der Objekt- und Greifergeometrie eine optimale Griffpose für das zielsichere Zugreifen ermittelt. Das gegriffene Objekt wird anschließend zu einem Ablagebereich transportiert.

Der Demonstrator veranschaulicht, dass mit geringem Aufwand ein System zur Erkennung von Objekten und einer daran anschließenden Manipulation entwickelt und in bestehende Abläufe integriert werden kann

Transfer und Nachnutzbarkeit

Der Demonstrator zeigt, wie KI-Modelle zum Umweltverständnis eingesetzt werden können, um Maschinen intelligentes Handeln zu ermöglichen. Das Prinzip kann auf zahlreiche Anwendungsfälle übertragen werden, z.B. Transportroboter in Warenhäusern.

Genutzte Hardware

- Roboterarm TrossenRobotics WidowX 250s (6 DoF, 250g Payload)

- Intel Realsense D415 RGB- und Tiefenkamera

- RaspberryPi 4 8GB

- Peripherie: Monitor, Ringlicht